SEMRF:リアルタイムの大規模シーン探索のためのストリーミング可能なメモリ効率の高い放射輝度フィールド

SEMRF:Streamable Memory Efficient Radiance Fields

先日、別記事に書きました「MERF」に「Streamable」の「S」が追加されたものが、2023年12月12日に発表されました。

Streamable は「ストリーミング可能な」という意味です。

つまり、従来よりも軽い負荷で3D Radiance Fieldsのシーンを(リアルタイムに!?)配信可能にする技術になります。

2023年は、これらNeRFやGaussian Splattingの新しい技術が多く発表されました。この流れは、BtoBのデジタルツイン界隈だけでなく、ゲームやメタバースも含めて40年間ポリゴンメッシュが常識だった3D業界全体のゲームチェンジャーとなる可能性が非常に高いと思われます。

今回は上記「SEMRF」について、Googleと独テュービンゲン大学のチームからGitHubに公開されている記事を、日本語に翻訳して記録しておきたいと思います。

引用:SMERF: Streamable Memory Efficient Radiance Fields for Real-Time Large-Scene Exploration

SMERF : リアルタイムの大規模シーン探索のためのストリーミング可能なメモリ効率の高い放射輝度フィールド

-

- Daniel Duckworth*1

- Peter Hedman*2

- Christian Reiser2,4

- Peter Zhizhin2

- Jean-François Thibert3

- Mario Lučić1

- Richard Szeliski2

- Jonathan T. Barron2

- Google DeepMind1

- Google Research2

- Google Inc.3

- Tübingen AI Center, University of Tübingen4

- equal contribution*

概要

リアルタイム ビュー合成の最近の技術は、忠実度と速度が急速に進歩しており、最新の方法では、インタラクティブなフレーム レートでフォトリアリスティックに近いシーンをレンダリングできます。同時に、ラスタライゼーションに適した明示的なシーン表現と、レイ マーチングに基づいて構築されたニューラル フィールドとの間に緊張が生じており、後者の最先端のインスタンスは品質において前者を上回っていますが、リアルタイム アプリケーションとしては法外に高価です。この研究では、体積解像度 3.5 mm^3 で最大 300 m^2 のフットプリントを持つ大規模シーンでリアルタイム手法の中でも最先端の精度を達成するビュー合成アプローチである SMERF を紹介します。私たちの手法は 2 つの主な貢献に基づいて構築されています。1 つは計算とメモリの消費を制限しながらモデルの容量を増加させる階層モデル分割スキーム、もう 1 つは高い忠実性と内部一貫性を同時にもたらす蒸留トレーニング戦略です。私たちのアプローチにより、Web ブラウザ内で完全な 6 自由度 (6DOF) のナビゲーションが可能になり、市販のスマートフォンやラップトップでリアルタイムにレンダリングが可能になります。広範な実験の結果、私たちの方法はリアルタイムのノベルビュー合成における現在の最先端技術を標準ベンチマークで 0.78 dB、大規模シーンで 1.78 dB 上回り、フレームのレンダリングが最先端のものより 3 桁高速であることがわかりました。アート ラディアンス フィールド モデルを構築し、スマートフォンを含むさまざまなコモディティ デバイスにわたってリアルタイム パフォーマンスを実現します。

ビデオ

リアルタイム インタラクティブ ビューアーのデモ

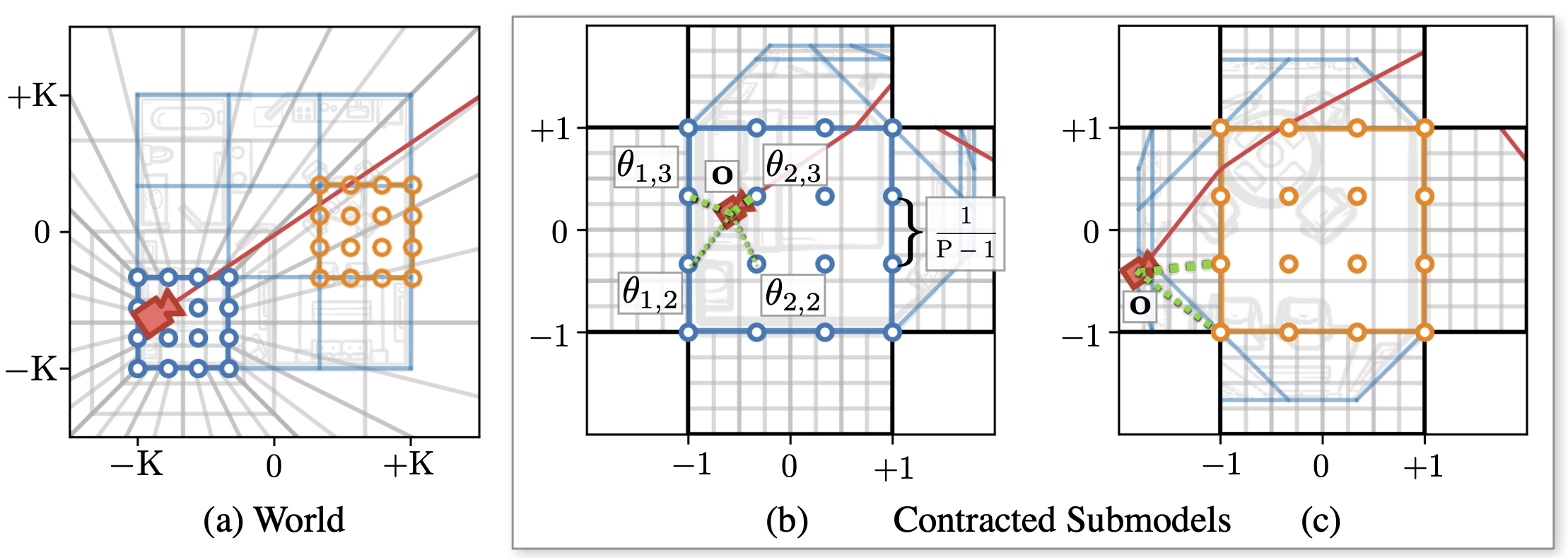

大規模なシーンを処理するために表現力を高める方法

(a) : 多数の独立したサブモデルを使用して大規模なマルチルーム シーンをモデル化し、それぞれがシーンの異なる領域に割り当てられます。レンダリング中に、サブモデルはカメラの原点に基づいて選択されます。(b) : 複雑なビュー依存の効果をモデル化するために、各サブモデル内で、遅延 MLP パラメーターのグリッドに位置合わせされたコピーを追加でインスタンス化します。これらのパラメータはカメラの原点に基づいて三重線形に補間されます。(c) : 各サブモデルはシーン全体を表しますが、サブモデルに関連付けられたグリッド セルのみが高解像度でモデル化されます。これは、サブモデル固有のローカル座標を縮小することによって実現されます。

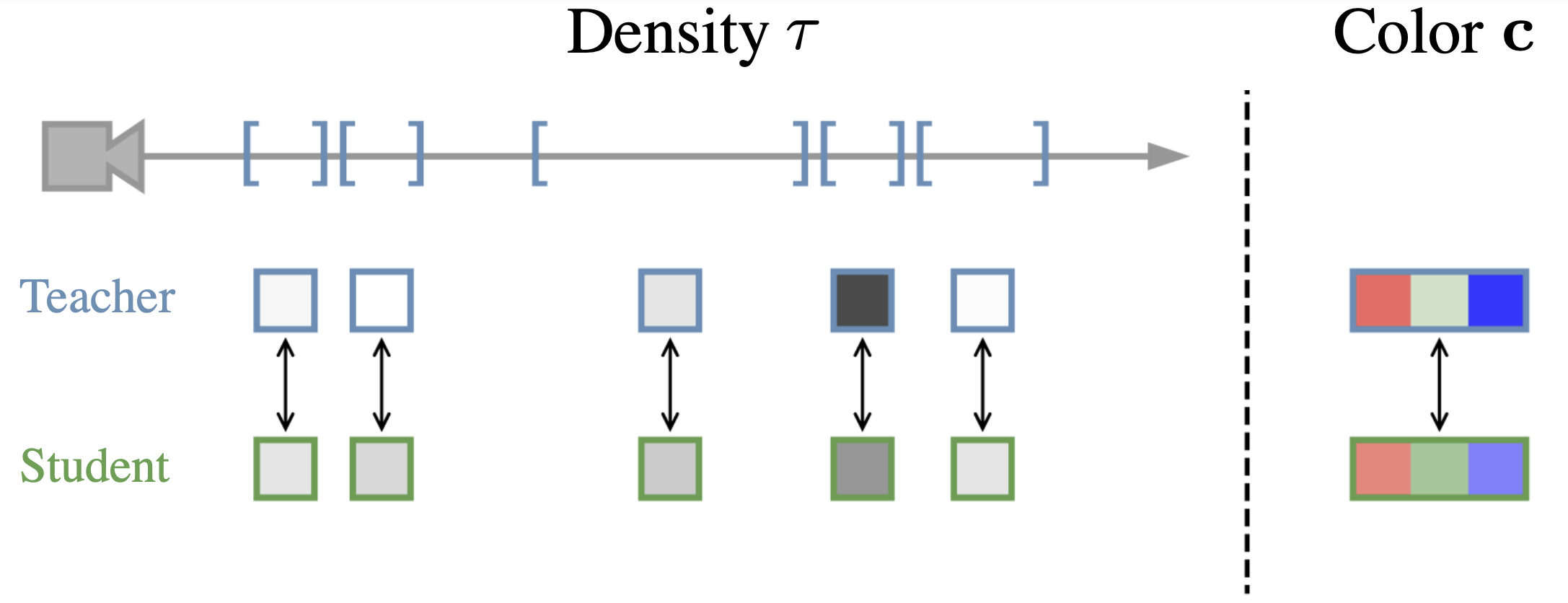

蒸留によって表現を最大限に引き出す

私たちは、蒸留によって画像の忠実度が大幅に向上することを実証します。まず、最先端のオフライン放射フィールド (Zip-NeRF) をトレーニングします。次に、RGB カラー予測を使用します。この教師モデルを私たち自身のモデルの監督として使用します。さらに、体積密度の値にアクセスします。

教師と生徒の間のボリューム レンダリング ウェイトの不一致を最小限に抑えることで、事前トレーニングを受けた教師のパフォーマンスを向上させます。

引用

@misc{duckworth2023smerf,

title={SMERF: Streamable Memory Efficient Radiance Fields for Real-Time Large-Scene Exploration},

author={Daniel Duckworth and Peter Hedman and Christian Reiser and Peter Zhizhin and Jean-François Thibert and Mario Lučić and Richard Szeliski and Jonathan T. Barron},

year={2023},

eprint={2312.07541},

archivePrefix={arXiv},

primaryClass={cs.CV}

}